De belofte en de schrik van AI-tools

Een leverancier komt met een AI-oplossing die al je problemen lijkt op te lossen: een chatbot die klanten direct helpt, een analyse-tool die bergen data in minuten verwerkt of een slimme assistent die documenten opstelt. De pitch klinkt vlekkeloos en de prijs valt mee.

Maar stel dat je later ontdekt dat klantgegevens op servers buiten de EU staan? Of dat er geen logboeken zijn om te bewijzen wie toegang had? Precies daar gaat het mis. In de praktijk blijkt dat organisaties pas tijdens een DPIA of, erger nog, na een incident ontdekken dat er grote gaten in de afspraken met hun AI-leverancier zitten.

Om dat te voorkomen, is een due-diligenceproces onmisbaar.

Praktijkvoorbeeld: AI in de klantenservice

Een MKB-bedrijf besloot een AI-chatbot in te zetten voor hun klantenservice. Alles leek goed geregeld: het contract was getekend en de tool werkte prima. Totdat een klant vroeg om inzage in zijn gegevens.

Toen bleek: gesprekken waren opgeslagen op servers buiten de EU, er was geen verwerkersovereenkomst en er bestond geen procedure om data te verwijderen. Het bedrijf moest in allerijl schakelen, met boze klanten en reputatieschade tot gevolg.

Met een due-diligenceproces vooraf waren deze problemen grotendeels te voorkomen geweest.

Waarom due diligence bij AI cruciaal is

Voor veel Mkb’s voelt het logisch om snel in te stappen bij een AI-tool. Maar de risico’s zijn vaak groter dan bij traditionele software. Data kan ongemerkt terecht komen bij onderaannemers of gebruikt worden voor modeltraining. Zonder goede logging is het onmogelijk om aan te tonen wie at met welke data deed. Een ISO-certificaat of keurmerk geeft bovendien een valse zekerheid als contracten en processen niet op orde zijn> Daarbovenop komt nieuwe regelgeving, zoals de Europese AI-verordening, die extra verplichtingen meebrengt voor leveranciers én afnemers.

Juist omdat AI zich razendsnel ontwikkelt, is due diligence geen vinkje, maar een doorlopend proces.

DPIA: verplicht waar nodig, nuttig altijd

Volgens de AVG is een DPIA (Data Protection Impact Assessment) verplicht bij verwerkingen met een waarschijnlijk hoog risico voor betrokkenen. Denk aan grootschalige monitoring, gebruik van bijzondere persoonsgegevens of innovatieve technologie. AI valt daar vaak onder.

Ook als het formeel niet verplicht is, loont een DPIA. Het dwingt je om drie vragen concreet te beantwoorden:

- Welke persoonsgegevens worden verwerkt?

- Welke risico’s lopen betrokkenen?

- Welke maatregelen neemt de leverancier om die risico’s te beperken?

Een DPIA is dus niet alleen een juridische verplichting, maar ook een nuttig hulpmiddel om jouw due diligence te structureren.

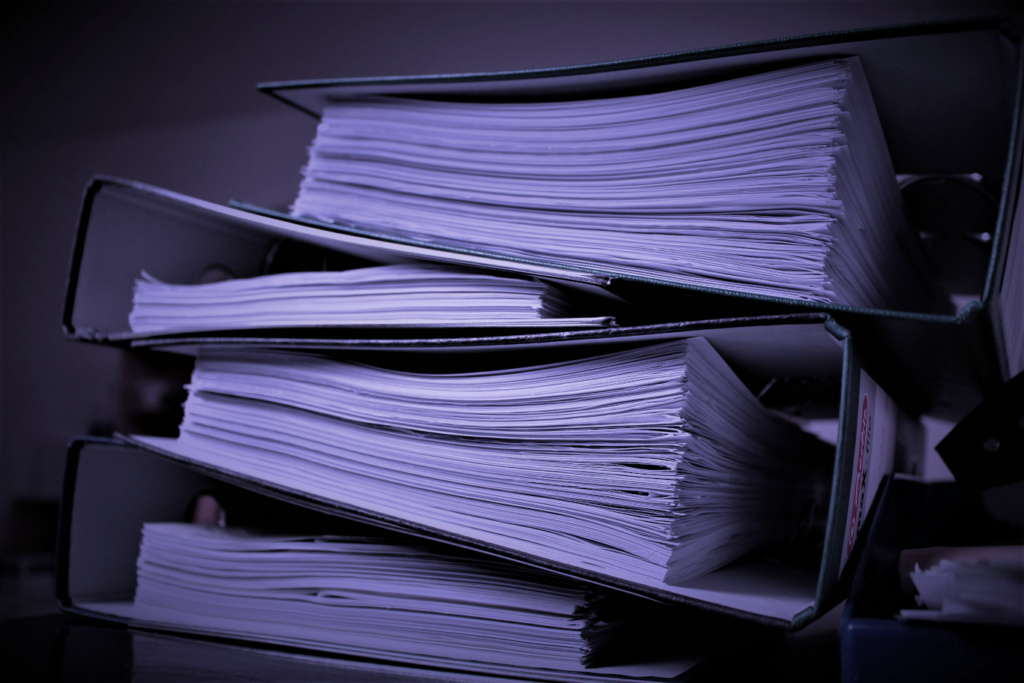

De due-diligence checklist voor AI-leveranciers

1. Contract en data-eigenaarschap

Leg vast dat jouw organisatie eigenaar blijft van alle aangeleverde data. Bepaal bewaartermijnen en maak afspraken over subverwerkers. Vraag om aantoonbare maatregelen, zoals ISO 27001 of een gelijkwaardige standaard, maar geef ook ruimte aan kleinere leveranciers die andere vormen van bewijs kunnen leveren.

2. Logging en transparantie

Vraag minimaal om inzage in trainingslogs: wie had wanneer toegang tot welke data? Idealiter levert de leverancier exporteerbare logbestanden, maar zelfs eenvoudige rapportages zijn al een stap vooruit. Zonder logging is compliance aantonen vrijwel onmogelijk.

3. Datapaden en modeltraining

Vraag welke databronnen zijn gebruikt voor de training van het AI-model. Leg vast dat jouw data niet zonder toestemming wordt gebruikt voor verdere training. Controleer of doorgifte naar landen buiten de EU goed geregeld is (bijvoorbeeld via SCC’s of een adequaatheidsbesluit).

4. Incidentrespons en meldplicht

Spreek een meldtermijn van 24-48 uur af, zodat jij je eigen 72-uurs verplichting onder de AVG kunt halen. Vraag hoe eerdere incidenten zijn afgehandeld en of er een draaiboek beschikbaar is.

5. Privacyrechten en AVG-afspraken

Zorg voor een duidelijke verwerkersovereenkomst. Controleer of de leverancier het mogelijk maakt om inzage-, correctie- en verwijderverzoeken uit te voeren. Betrek ook hun DPO of privacy-officer in het proces.

Hoe CompliTrack dit proces ondersteunt

Due diligence hoeft geen papieren tijger te zijn. Met CompliTrack kun je dit proces slim en eenvoudig organiseren:

- Leveranciers koppelen aan bedrijfsmiddelen: je ziet direct welke leveranciers toegang hebben tot welke kritieke processen of data.

- DPIA’s centraal beheren: voer DPIA’s stap voor stap uit en leg bevindingen vast in één overzicht.

- Taken en controles automatiseren: stel terugkerende beoordelingen in zodat je niets vergeet.

- Auditklaar overzicht: toon met één druk op de knop welke maatregelen en afspraken zijn gemaakt.

Voor ondernemers betekent dit: minder afhankelijk van losse Excel-lijstjes en meer grip zonder zware systemen.

Interne links en verdieping

Deze blog maakt deel uit van de serie rond AI-governance. Wil je verder lezen?

- In AI-governance deel 1: beleid en risico’s lees je hoe je beleid en controles rondom AI vormgeeft

- In Leveranciers beoordelen zonder spreadsheets ontdek je hoe je leveranciers structureel in beeld brengt.

- In GRC-software in 90 dagen vind je een praktisch implementatieplan om dit alles in je organisatie werkbaar te maken.

Conclusie: AI zonder due diligence is een gok

AI kan het MKB enorme kansen bieden, maar ook forse risico’s. Zonder due diligence loop je het gevaar dat je pas na een incident ontdekt dat de afspraken tekortschieten.

Met de checklist in dit artikel, gecombineerd met een DPIA, heb je een solide basis om je AI-leveranciers verantwoord te beoordelen. Voeg daar een tool als CompliTrack aan toe en je bent voorbereid op audits, klanten en toezichthouders.

Wil je weten hoe CompliTrack jouw organisatie kan helpen bij AI-governance en leveranciersbeheer? Vraag een demo aan en ontdek het verschil.